Sprachmodelle leisten keine kognitive Arbeit

Künstliche Intelligenz (KI) ist in den Medien, aber sie besteht nur aus Sprachsimulationen

|

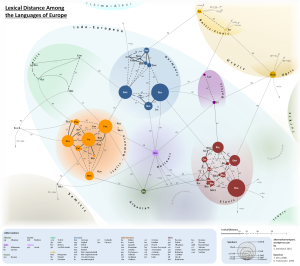

Lexical Distance Map (Grafik: Stephan Steinbach, www.alternativetransport.wordpress.com) |

Wien (pts014/30.08.2023/09:30)

Folgt man der Logik der derzeit unter dem KI-Etikett angebotenen Produkte, so ließe sich der Fachkräftemangel im Sektor Informationstechnologie leicht beheben. Man nehme beliebige Personen und lasse sie einige Monate lang Tutorials, Code-Beispiele, Trainingsvideos und andere Dokumente konsumieren, die mit dem Einsatzgebiet zusammenhängen. Nach dieser Lernphase stünden automatisch Fachkräfte zur Verfügung. Die DeepSec Konferenz fragt sich daher, wieso es noch personelle Engpässe in der Informationstechnologie geben kann. Algorithmisch scheint das Problem ja bereits gelöst.

Large Language Models (LLMs) und KI

Die sogenannte generative KI, die jetzt in aller Munde ist, ist mathematisch dem Forschungsfeld der Künstlichen Intelligenz zugeordnet. GPT, LLaMa, LaMDA oder PaLM sind Modelle, die von Google, Meta und OpenAI (unterstützt von Microsoft) auf den Markt geworfen wurden. Es gibt weitere Modelle, die frei oder begrenzt zur Verfügung stehen. Alle sind sogenannte Large Language Models (LLMs). Diese Klasse von Algorithmen zeichnet sich durch die enorme Größe an Lerndaten aus, die für das Training verwendet wurden. Durch Fragen, auch Prompts genannt, stellen die Algorithmen dann eine Antwort aus Teilen der gelernten Daten zusammen. Die Modelle analysieren dazu die Muster der Sprachen, die sie "gelernt" haben. Generiert wird dann eine verkürzte Mischung der Lerndaten, die sprachlich gut formuliert ausgegeben wird. Das ist dann die Antwort auf eine Frage. Neues Wissen oder Erkenntnisse entstehen dabei nicht, auch eine inhaltliche Analyse findet nicht statt.

Sprechen und Schreiben ist nicht Denken

LLMs simulieren weder einen Denkprozess, noch führen sie ihn durch. Die Ausgabe klingt gut und kann auch syntaktisch korrekt sein (beispielsweise, wenn statt Sprache Code generiert wird). Es handelt sich um digitale Papageien mit sehr großem Wortschatz. Dazu gibt es eine wissenschaftliche Publikation mit dem Titel "On the Dangers of Stochastic Parrots: Can Language Models Be Too Big?", welche die Größe der für die Modelle eingesetzten Lerndaten kritisch hinterfragt. Die Fragestellung beleuchtet auch die Risiken der Technologie und wie man diesen begegnet. Die Autorinnen kommen zu dem Ergebnis, dass das Rennen nach immer komplexeren Sprachmodellen und Sammlungen von Lerndaten nur bedingt Vorteile hat. Der Betrieb der Algorithmen im Zustand nach dem Anlernen hat finanzielle und umwelttechnische Kosten. Die Ergebnisse des Aufwands sind nicht vorhersehbar (alle bisher publizierten und verwendeten Modelle sind Prototypen, also ein Experiment). Die Größe und Komplexität erschwert den Zugang von Forscherinnen und Forschern für wissenschaftliche Analysen. Zusätzlich bedeutet die hohe Eloquenz der Antworten der LLM-Algorithmen ein Risiko hinsichtlich gedankenloser Übernahme von Falschinformationen.

LLM-Algorithmen haben Halluzinationen

Es gibt weitere Studien, die sich mit den Ausgaben von falschen Informationen der Sprachmodelle beschäftigt haben. Die Ursache liegt einerseits im Alter der Lerndaten. GPT-4 hat nur Daten bis September 2021 gelernt. Alle Informationen, die jünger sind, sind nicht Teil des Korpus und können nicht für Antworten herangezogen werden. Weitere Gründe sind Widersprüche in den Lerndaten, Ungenauigkeiten bei der Datensammlung vor dem Lernprozess oder unvollständige Quellen. Alle diese Faktoren können zu generierten Antworten führen, die bestenfalls irreführend oder im schlimmsten Fall einfach falsch sind. Einfache Lösungen gibt es für das Problem nicht. Das bedeutet, dass momentan falsche Antworten, wenn sie bekannt werden, nachträglich durch Anpassung der Konfiguration herausgefiltert. Dies geschieht bei den Anbietern der Sprachmodelle. Der Betrieb der Modelle wird dadurch im Laufe der Zeit immer komplizierter, weil ständig neue Filter dazukommen.

Bezug zur Informationssicherheit

Generative KI-Algorithmen sollen auch in der Informationssicherheit eingesetzt werden. Ein Fokus ist dort das Herausfiltern von Informationen aus großen Datenmengen (eben den Lerndaten). Deren Einsatz klingt verlockt, aber die Ergebnisse dürfen dann nicht Teil einer Halluzination sein, denn Antworten auf Fragestellungen bei Sicherheitsfragen müssen klare und belastbare Aussagen treffen. Auf der diesjährigen DeepSec Konferenz werden Vor- und Nachteile der LLM-Algorithmen im Zusammenhang mit Sicherheit diskutiert. Ein Anwendungsfall ist die Unterstützung bei der Analyse von Sicherheitsvorfällen. In diesen Szenarien hat man sehr viele Daten auszuwerten, wo die Verknüpfung von Mustern in den Datensammlungen hilfreich sein kann.

Programme und Buchung

Die DeepSec 2023-Konferenztage sind am 16. und 17. November. Die DeepSec-Trainings finden an den zwei vorangehenden Tagen, dem 14. und 15. November, statt. Alle Trainings (bis auf angekündigte Ausnahmen) und Vorträge sind als Präsenzveranstaltung geplant. Für registrierte Teilnehmer und Teilnehmerinnen wird es einen Stream der Vorträge auf unserer Internetplattform geben.

Die DeepINTEL Security Intelligence Konferenz findet am 15. November statt. Da es sich um eine geschlossene Veranstaltung handelt, bitten wir um direkte Anfragen zum Programm an unsere Kontaktadressen. Wir stellen dafür starke Ende-zu-Ende-Verschlüsselung bei Kommunikation mit uns zur Verfügung: https://deepsec.net/contact.html

Tickets für die DeepSec Konferenz und die Trainings können Sie jederzeit online unter dem Link https://deepsec.net/register.html bestellen. Ermäßigungscodes von Sponsoren stehen Ihnen zur Verfügung. Bei Interesse melden Sie sich bitte unter deepsec@deepsec.net. Bitte beachten Sie, dass wir wegen der Planungssicherheit auf rechtzeitige Ticketbestellungen angewiesen sind.

(Ende)| Aussender: | DeepSec GmbH |

| Ansprechpartner: | René Pfeiffer |

| Tel.: | +43 676 56 26 390 |

| E-Mail: | deepsec@deepsec.net |

| Website: | deepsec.net/ |