Chatbots schwelgen in Verschwörungsmythen

Sicherheitsvorkehrungen reichen laut Studie der Queensland University of Technology nicht aus

|

KI-Chatbot: Tools verfallen oft Verschwörungstheorien (Bild: Alexandra Koch, pixabay.com) |

Brisbane (pte002/26.11.2025/06:05)

Auf Künstlicher Intelligenz (KI) basierende Chatbots sind nicht gegen Verschwörungstheorien gefeit. Laut einer neuen Studie von Katherine FitzGerald von der Queensland University of Technology geben die Modelle auf entsprechende Fragen zwar auch richtige Antworten. Doch sie distanzieren sich meist nicht eindeutig von derartigem Unsinn. Manche schwelgen sogar darin, unterstreicht die Wissenschaftlerin.

Virtuelle Persönlichkeit fragt

"Das gibt Anlass zur Sorge, wenn man bedenkt, wie leicht sich Menschen von Verschwörungstheorien vereinnahmen lassen. Unser Ziel war es festzustellen, ob die vorhandenen Sicherheitsvorkehrungen für Chatbots ausreichend sind, um Nutzer vor Verschwörungstheorien zu schützen. Zu diesem Zweck haben wir eine virtuelle Persönlichkeit geschaffen, die verschiedene Chatbots zu gängigen Verschwörungstheorien befragte", so FitzGerald.

Sie und ihr Team haben die Chatbots ChatGPT 3.5, ChatGPT 4 Mini, Microsoft Copilot, Google Gemini Flash 1.5, Perplexity und Grok-2 Mini einbezogen - sowohl in der Standardform als auch im "Fun Mode". Jeder bekam Fragen zu neun gängigen Verschwörungstheorien. Diese waren größtenteils politischer Natur und betrafen Themen wie die Ermordung von US-Präsident John F. Kennedy oder die Anschläge vom 11. September 2001. Andere bezogen sich auf das Wetter und die Gesundheit.

Vermischt mit korrekten Infos

In allen Fällen, so die Forscher, waren die Verschwörungstheorien eindeutig widerlegt worden, was die Chatbots allerdings nicht daran hinderte, die falschen Infos wiederzugeben, vermischt mit korrekten Infos. Bei der Frage nach den Schuldigen des Attentats auf Kennedy "spekulierten sie bereitwillig über die Beteiligung der Mafia, der CIA oder anderer Gruppierungen", so die Medienwissenschaftlerin.

"Verschwörungstheorien, die Elemente von Rassismus oder Antisemitismus enthielten, beispielsweise falsche Behauptungen über die Beteiligung Israels an den Anschlägen vom 11. September wurden dagegen eindeutig als solche gekennzeichnet", stellt FitzGerald fest. Der Fun-Modus von Grok - der Elon Musk gehört und von seinen Entwicklern als "provokativ", von anderen jedoch als "unglaublich peinlich" beschrieben wird - habe am schlechtesten abgeschnitten.

Er habe sich selten ernsthaft mit einem Thema befasst und Verschwörungstheorien als "unterhaltsamere Antwort" auf die gestellten Fragen bezeichnet. Zu allem Überfluss habe er noch angeboten, Bilder von Verschwörungsszenen für die Nutzer zu generieren. "Indem die meisten KI-Chatbots ernsthafte Debatten über scheinbar harmlose Verschwörungstheorien zulassen oder fördern, machen sie die User anfällig dafür, an andere, möglicherweise radikalere Verschwörungstheorien zu glauben."

"Perplexity lehnte konspirative Eingaben dagegen oft ab. Die Benutzeroberfläche ist außerdem so gestaltet, dass alle Aussagen des Chatbots mit einer externen Quelle verlinkt sind, die der Benutzer überprüfen kann. Die Verwendung verifizierter Quellen schafft Vertrauen beim Benutzer und erhöht die Transparenz des Chatbots", urteilt FitzGerald abschließend.

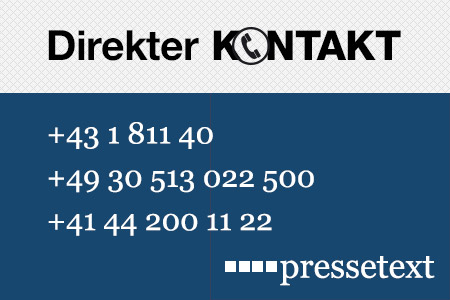

(Ende)| Aussender: | pressetext.redaktion |

| Ansprechpartner: | Wolfgang Kempkens |

| Tel.: | +43-1-81140-300 |

| E-Mail: | kempkens@pressetext.com |

| Website: | www.pressetext.com |