KI: Rassistische Vorurteile kaum erkannt

Neue Untersuchung von Forschern der Penn State zeigt, dass Nutzer die KI für neutral halten

|

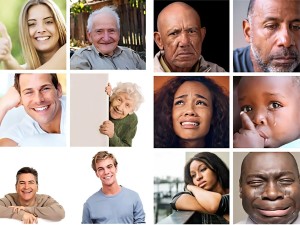

Gesichtsausdrücke: KI zeigt nicht selten viele rassistische Vorurteile (Bild: psu.edu) |

University Park (pte002/20.10.2025/06:05)

Die meisten Nutzer können rassistische Vorurteile einer Künstlichen Intelligenz (KI) nicht erkennen. Zu diesem Ergebnis kommen Forscher der Pennsylvania State University. In ihrer kürzlich in "Media Psychology" veröffentlichten Studie haben sie 769 Probanden gebeten, solche verzerrten KI-Trainingsdaten zu bewerten. Aber die meisten bemerkten die Voreingenommenheit nicht - es sei denn, sie gehörten selbst zur negativ dargestellten Gruppe.

Glücklichere Weiße

Bei der Erkennung von Gesichtern und Emotionen kann KI voreingenommen sein, etwa indem sie weiße Menschen als glücklicher einstuft als Menschen anderer ethnischer Herkunft. Das passiert, weil die zum Trainieren der KI verwendeten Daten eine unverhältnismäßig hohe Anzahl glücklicher weißer Gesichter enthielten, was dazu führte, dass die KI ethnische Zugehörigkeit mit emotionalem Ausdruck in Verbindung brachte.

Die Wissenschaftler wollten herausfinden, ob Laien verstehen, dass nicht repräsentative Daten, die zum Trainieren von KI-Systemen verwendet werden, zu einem verzerrten Bild führen können. Sie plädieren dafür, KI-Systeme so zu trainieren, dass sie "für alle funktionieren" und Ergebnisse liefern, die vielfältig und repräsentativ für alle Gruppen sind, nicht nur für eine Mehrheit.

"Im Fall dieser Studie scheint die KI gelernt zu haben, dass die ethnische Zugehörigkeit ein wichtiges Kriterium für die Bestimmung ist, ob ein Gesicht glücklich oder traurig ist", sagt der leitende Autor S. Shyam Sundar. "Auch wenn wir nicht beabsichtigen, dass sie das lernt."

Challenge Klassifizierung

Die Frage ist, ob Menschen diese Verzerrung in den KI-Trainingsdaten erkennen können. Den Forschern zufolge bemerkten die meisten Teilnehmer ihrer Experimente die Verzerrung erst, als die KI eine verzerrte Leistung zeigte, zum Beispiel, indem sie Emotionen schwarzer Personen falsch klassifizierte, aber jene von weißen Personen gut klassifizierte. Schwarze Teilnehmer vermuteten eher, dass es ein Problem gab, speziell wenn die Daten ihre eigene Gruppe bei der Darstellung negativer Emotionen (Traurigkeit) überrepräsentierten.

"Wir waren überrascht, dass die Menschen nicht erkannten, dass Rasse und Emotion miteinander vermischt waren, dass eine Rasse eher als andere dazu neigte, eine bestimmte Emotion in den Trainingsdaten darzustellen - selbst wenn es ihnen direkt ins Gesicht sprang. Für mich ist das die wichtigste Erkenntnis der Studie", sagt Sundar. Menschen würden oft davon ausgehen, dass KI neutral sei, auch wenn sie das nicht ist.

In künftigen Forschungen geht es den Autoren um die Entwicklung und Erprobung besserer Methoden, um Nutzern, Entwicklern und Politikern die der KI innewohnenden Verzerrungen zu vermitteln. Die Forscher wollen weiterhin untersuchen, wie Menschen algorithmische Verzerrungen wahrnehmen und verstehen, indem sie sich auf die Verbesserung der Medien- und KI-Kompetenz fokussieren.

(Ende)| Aussender: | pressetext.redaktion |

| Ansprechpartner: | Lutz Steinbrück |

| Tel.: | +43-1-81140-300 |

| E-Mail: | steinbrueck@pressetext.com |

| Website: | www.pressetext.com |