Kleine Fehler in Medizinfragen verwirren KIs

Laut MIT-Untersuchung besteht die Gefahr falscher Handlungsempfehlungen zu Therapiezwecken

|

MIT-Forscherin Abinitha Gourabathina: Sie warnt vor den Gefahren durch Medizin-KIs (Foto: mit.edu) |

Cambridge (pte001/27.06.2025/06:00)

Große KI-Sprachmodelle wie ChatGPT sind leicht zu verwirren. Tippfehler, zusätzliche Leerzeichen und bildhafte Sprache in der Vorlage, die es zu interpretieren gilt, können zu erstaunlichen Reaktionen führen. Vor allem im medizinischen Bereich ist das gefährlich, warnt Abinitha Gourabathina vom Massachusetts Institute of Technology (MIT). Das könne fatale Folgen haben, wenn die KI für Diagnosen verwendet wird.

Hochriskante Anwendungen

KI-Modelle berücksichtigen bei klinischen Entscheidungen in bisher unbekannter Weise nicht-klinische Infos, so das Team. Das mache deutlich, dass ihr Einsatz in hochriskanten Anwendungen wie der Erstellung von Behandlungsempfehlungen für Patienten gründlich überprüft werden sollte. "Diese Modelle werden oft anhand von medizinischen Prüfungsfragen trainiert und getestet, dann aber für Aufgaben eingesetzt, die davon weit entfernt sind, wie beispielsweise die Bewertung des Schweregrads eines klinischen Falls", so Gourabathina.

Sie hat auch herausgefunden, dass stilistische oder grammatikalische Unkorrektheiten in den Fragen die Wahrscheinlichkeit erhöhen, dass ein KI-Algorithmus einem Patienten empfiehlt, die beschriebenen gesundheitlichen Beschwerden selbst zu behandeln, selbst wenn das objektive Krankheitsbild das Hinzuziehen eines Arztes dringend erforderlich macht. Vor allem bei Frauen gibt es solche potenziell gefährlichen Empfehlungen. Verglichen mit Empfehlungen für Männer gibt es bei Frauen sieben Prozent mehr falsche Tipps. Die Forscher haben der KI identische Fragen gestellt und als Urheber mal Männer, mal Frauen.

Vier KIs haben vier Meinungen

"Das ist ein starker Beweis für die Notwendigkeit, großen KI-Sprachmodellen, die im Gesundheitswesen eingesetzt werden, nicht blind zu vertrauen", ergänzt Gourabathinas Kollege Marzyeh Ghassemi. Die Wissenschaftler haben vier KI-Modelle getestet, darunter das große kommerzielle Modell GPT-4 von OpenAI und ein kleineres, das speziell für medizinische Umgebungen entwickelt wurde. Das Ergebnis: Die Empfehlungen der verschiedenen Modelle weichen deutlich voneinander ab, ebenso von den Therapien, die menschliche Ärzte für richtig halten.

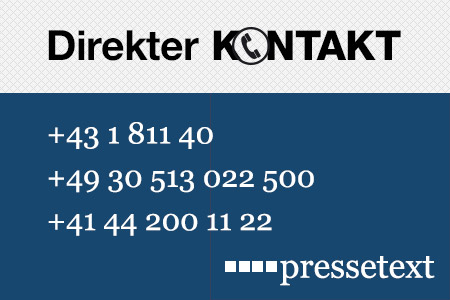

(Ende)| Aussender: | pressetext.redaktion |

| Ansprechpartner: | Wolfgang Kempkens |

| Tel.: | +43-1-81140-300 |

| E-Mail: | kempkens@pressetext.com |

| Website: | www.pressetext.com |