Neuer Roboter sieht, hört und fühlt Umfeld

"WildFusion" ermöglicht beste Orientierung in unbekanntem Terrain nach menschlichem Vorbild

|

"WildFusion" in Aktion: Zusatzsensoren machen Roboter noch unabhängiger (Foto: duke.edu) |

Durham (pte019/20.05.2025/11:30)

Mit "WildFusion" von Forschern der Duke University ausgestattete Roboter können sich in unbekannter Umgebung ähnlich sicher bewegen wie Menschen. Das System der Ingenieure gibt den Robotern einen Tastsinn, die Möglichkeit zu sehen und Vibrationen zu spüren.

Überall sicheres Agieren

"WildFusion schlägt ein neues Kapitel in der Roboter-Navigation und 3D-Kartierung auf. Es hilft Robotern, in unstrukturierten, unvorhersehbaren Umgebungen wie Wäldern, Katastrophengebieten und Geländen abseits der Straße sicherer zu agieren", so Entwickler Boyuan Chen. "Herkömmliche Roboter sind stark auf Bildverarbeitung oder LiDAR angewiesen, was ohne klare Wege oder vorhersehbare Orientierungspunkte oft zu Fehlern führt", ergänzt Chens Doktorand Yanbaihui Liu.

Selbst fortschrittliche 3D-Kartierungsmethoden haben laut den Wissenschaftlern Schwierigkeiten, eine lückenlose Karte zu erstellen, wenn die Sensordaten spärlich, verrauscht oder unvollständig sind, was in unstrukturierten Außenbereichen häufig der Fall sei. Genau für diese Herausforderung sei WildFusion entwickelt worden.

Ausweitung der Sensorik

WildFusion ist für einen vierbeinigen Roboter konzipiert und integriert mehrere Sensoren, darunter eine RGB-Kamera, die Objekte in den Farben Rot, Grün und Blau aufnimmt. An Bord sind auch LiDAR, ein laserbasiertes Abstandsmessgerät, Trägheitssensoren sowie Kontaktmikrofone und taktile Sensoren. Wie bei herkömmlichen Ansätzen erfassen die Kamera und LiDAR Geometrie, Farbe, Entfernung und visuelle Details der Umgebung. Dazu kommen Infos der zusätzlichen Sensoren.

Während der Roboter läuft, zeichnen die Kontaktmikrofone charakteristische Vibrationen auf, die bei jedem Schritt entstehen, und erfassen dabei subtile Unterschiede, wie das Knirschen trockener Blätter oder das Schmatzen der Füße, wenn sie in Schlamm waten. Gleichzeitig messen taktile Sensoren, wie viel Kraft auf jeden Fuß ausgeübt wird, sodass der Roboter in Echtzeit Stabilität oder Rutschgefahr erkennen kann.

Diese zusätzlichen Sinne werden durch einen Trägheitssensor ergänzt, der Beschleunigungsdaten erfasst, um zu beurteilen, wie stark der Roboter beim Überqueren von unebenem Boden wackelt, kippt oder rollt. Alle Sensordaten werden vom Bordcomputer verarbeitet und genutzt, um die Stabilität des Roboters in jeder Situation zu erhalten. Das Herzstück von WildFusion ist ein Deep-Learning-Modell, das mit allen Untergründen und Umgebungen trainiert worden ist. So kann der Roboter intelligentere und intuitivere Entscheidungen darüber treffen, wo er hintreten soll, selbst wenn seine Sicht versperrt oder unklar ist.

(Ende)

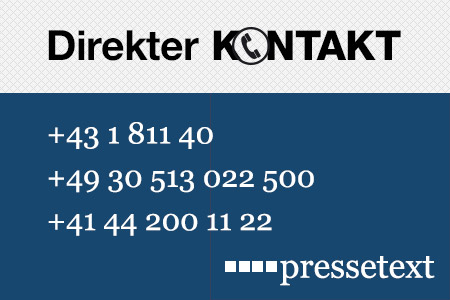

| Aussender: | pressetext.redaktion |

| Ansprechpartner: | Wolfgang Kempkens |

| Tel.: | +43-1-81140-300 |

| E-Mail: | kempkens@pressetext.com |

| Website: | www.pressetext.com |