Gefälschte Videos bald nicht mehr zu erkennen

KI-Forscher der Humboldt-Universität zeigen die Grenzen herkömmlicher Erkennungsverfahren

|

Peter Eisert: KI-Wissenschaftler sieht neue Deepfake-Gefahren (Foto: hu-berlin.de) |

Berlin (pte001/02.05.2025/06:00)

Mit Künstlicher Intelligenz (KI) erstellte Fake-Videos zeigen oft keine Veränderungen in der Haut der dargestellten Menschen und lassen sich bisher gerade deshalb gut erkennen. Insbesondere fehlt es den Darstellungen bislang am Herzschlag und den sich daraus ergebenen Hautveränderungen. Doch auch hier holt die Technologie in Bezug auf Deepfakes auf, warnen Forscher der Humboldt-Universität zu Berlin.

Hautschattierungen und Puls

Die Experten haben eine naturnahe Haut und auch einen realistischen Pulsschlag simuliert. "Wir zeigen jetzt zum ersten Mal, dass aktuelle hochwertige Deepfake-Videos einen realistischen Herzschlag und winzige Veränderungen in der Gesichtsfarbe aufweisen können, wodurch sie viel schwieriger zu erkennen sind", so Peter Eisert, Spezialist für visuelle Datenverarbeitung.

Deepfake-Ersteller verändern beispielsweise Gesichtsausdrücke und Gesten in echten Videos und tauschen diese zwischen verschiedenen Personen aus. Ihre Absichten sind nicht unbedingt böswillig: Apps, mit denen sich Nutzer in eine harmlose Katze verwandeln oder digital altern lassen, sind beispielsweise sehr beliebt und ein bedenkenloser Freizeitspaß.

Erkennungsmethode scheitert

Die Analyse der Lichtreflektion durch die Haut und die darunter liegenden pulsierenden Blutgefäße wird in der Medizin zur Messung von Vitalparametern genutzt. Mit der gleichen Technik lassen sich heute noch Deepfakes entlarven. Eisert und seinen Kollegen ist es nun gelungen, Deepfakes so zu gestalten, dass dieses Verfahren nicht mehr funktioniert.

Die Wissenschaftler haben ein Video auf der Basis von Bildern einer realen Person angefertigt, in das sie die Hautschattierungen und deren Pulsieren übertrugen. Ein Deepfake-Detektor der neuesten Generation erkannte diese beiden Merkmale und bestätigte diese fälschlicherweise. Der Fake wurde fatalerweise also als echtes Video gekennzeichnet.

Eisert ist dennoch sicher, dass auch solche Deepfakes zu entlarven sind, allerdings mit einer neuen Strategie. "Wir müssen künftig nachweisen, dass in einem Video etwas unverändert geblieben ist statt zu erkennen, dass etwas gefälscht ist", unterstreicht der Forscher. Wenn es nichts Originales mehr gebe, sei es demzufolge eine Fälschung.

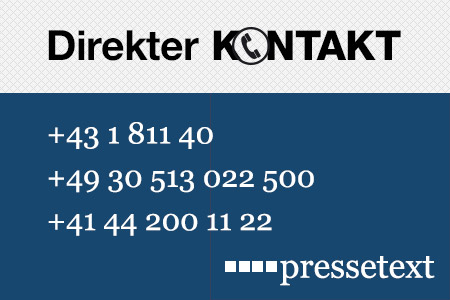

(Ende)| Aussender: | pressetext.redaktion |

| Ansprechpartner: | Wolfgang Kempkens |

| Tel.: | +43-1-81140-300 |

| E-Mail: | kempkens@pressetext.com |

| Website: | www.pressetext.com |