Algorithmen zeigen Menschen Vorurteile auf

Tests der Questrom School of Business - Fehler immer gerne zuerst beim Gegenüber gesehen

|

Algorithmen: Bias fast wie beim Menschen (Foto: pixabay.com, Markus Spiske) |

Boston (pte011/10.04.2024/12:30)

Die unbeabsichtigte Voreingenommenheit von KI-Algorithmen bringt laut einer Studie der Questrom School of Business jedoch auch Vorteile mit sich. Menschen erkennen demnach mehr ihrer Vorurteile in den Entscheidungen als sie es ohne die KI könnten. Das gilt sogar dann, wenn diese Entscheidungen gleich ausfallen. Carey Morewedge und Everett W. Lord schlagen in den "Proceedings of the National Academy of Sciences" Möglichkeiten vor, wie dieses Bewusstsein menschlichen Entscheidungsträgern dabei helfen könnte, ihre Vorurteile zu erkennen und zu korrigieren.

6.000 Personen getestet

Gemeinsam mit Begüm Çeliktutan und Romain Cadario von der Erasmus University hat Morewedge eine Reihe von Experimenten entwickelt, um soziale Vorurteile wie zum Beispiel Rassismus, Sexismus und Altersdiskriminierung zum Vorschein zu bringen. Die Forscher verglichen also die Wahrnehmung der Teilnehmer, wie diese Vorurteile ihre eigenen Entscheidungen einfärbten, mit den Entscheidungen, die von einem Algorithmus getroffen wurden. Manchmal sahen die Teilnehmer die Entscheidungen eines tatsächlichen Algorithmus. In anderen Fällen handelte es sich bei den als angeblich vom Algorithmus stammenden Entscheidungen, versteckt um die Wahl, die die Teilnehmer selbst getroffen hatten.

Insgesamt erkannten die Teilnehmer Vorurteile eher in den Entscheidungen, die angeblich von den Algorithmen stammten als in ihren eigenen. Sie sahen jedoch auch in Entscheidungen des Algorithmus gleich viele Fehleinschätzungen wie bei Entscheidungen anderer Menschen. Es gelingt Menschen demnach allgemein besser, Fehleinschätzungen bei anderen zu erkennen als bei sich selbst. Dieses Phänomen ist als "Bias Blind Spot" bekannt. Die Teilnehmer korrigierten die Verzerrungen in diesen Entscheidungen danach auch eher. Das könnte, so die Forscher, ein wichtiger Schritt zur Verringerung von Vorurteilen sein. Insgesamt wurden Experimente mit mehr als 6.000 Personen durchgeführt.

Weniger Verzerrung möglich

Im abschließenden Experiment sollten die Teilnehmer Fehleinschätzungen in ihren Beurteilungen oder jenen des Algorithmus korrigieren. Menschen waren eher bereit, die Entscheidungen des Algorithmus zu korrigieren. Damit verringerte sich auch die tatsächliche Verzerrung in diesen Bewertungen. Das ist laut Morewedge von entscheidender Bedeutung. Für jeden Mensch, der dazu bereit ist, seine Vorurteile zu verringern, ist die Fähigkeit, sie überhaupt wahrzunehmen, ein erster Schritt. Diese Forschungsergebnisse belegen, dass Algorithmen als eine Art Spiegel eingesetzt werden können. Dadurch wird es möglich, einen Bias zu identifizieren, auch wenn die Menschen dieses Falschurteil selbst gar nicht erkennen können.

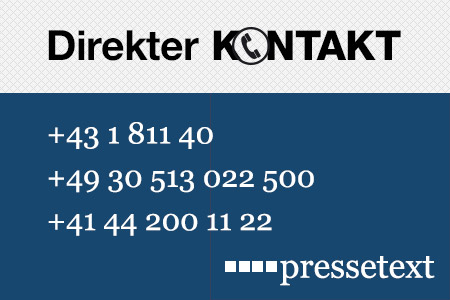

(Ende)| Aussender: | pressetext.redaktion |

| Ansprechpartner: | Moritz Bergmann |

| Tel.: | +43-1-81140-300 |

| E-Mail: | bergmann@pressetext.com |

| Website: | www.pressetext.com |