Gefühlserkennung: Roboter trainieren Mediziner

Maschinen und Avatare zeigen Emotionen wie Schmerz, Ärger und Ekel

|

Roboter: verfügt über bewegliche Gesichtszüge (Foto: humanrobotinteraction.org) |

San Diego/Graz (pte004/21.03.2017/06:15) Forscher der University of California, San Diego http://ucsd.edu haben Roboter und Avatare entwickelt, die Schmerz, Ekel und Ärger ausdrücken können. Im Vorfeld wurden Videos von Personen, die diese Emotionen zeigen, mithilfe einer Gesichtserkennungs-Software in eine Serie von 66 Bewegungspunkten umgewandelt. Diese sind anschließend auf dem Robotergesicht und dem Avatar abgebildet worden.

Humanoide Roboter genutzt

"Die künstliche Darstellung von Emotionen ist ein wichtiges Instrument der Robotik, um eine nonverbale Kommunikationsebene zwischen Roboter und Menschen bereitzustellen. Auch JOANNEUM RESEARCH - ROBOTICS arbeitet derzeit an der Darstellung von Gesichtsausdrücken für einen Roboterkopf. Hierbei versuchen wir robotertypische Zustandsformen, wie zum Beispiel 'Aufgabe verstanden', 'Aufgabe erledigt' oder auch 'Eingabe unverständlich' über Gesichtsausdrücke, mit teilweise unterstützenden Gesten, umzusetzen", erläutert Mathias Brandstötter von ROBOTICS - Institut für Robotik und Mechatronik der JOANNEUM RESEARCH Forschungsgesellschaft http://joanneum.at gegenüber pressetext.

Mit Kindern, Erwachsenen und älteren Menschen werde mit unterschiedlichen Augen- und Mundformen versucht, verständlich zu kommunizieren. "Aus der Erfahrung haben wir gelernt, dass ein Satz bekannter Emotionen viel einfacher für einen Menschen einzuordnen ist, als wenn die zu erkennenden Gesichtsausdrücke einem Menschen vorher nicht bekannt sind. Diese Herausforderung versucht ROBOTICS aktuell zu bewältigen", resümiert der Experte.

Bei dem verwendeten Roboter der University of California handelt es sich um den humanoiden Roboter des Unternehmens Hanson Robotics http://hansonrobotics.com , der den Science-Fiction-Autor Philip K Dick darstellt. Dieser verfügt über eine Gummihaut und kann seine Gesichtszüge bewegen. Die Forscher haben 102 Probanden Videos der Roboter und von virtuellen Avatare gezeigt. Von den Versuchsteilnehmern gehörten 51 zum medizinischen Fachpersonal, darunter Ärzte, Krankenschwestern und Pharmazeuten, während der Rest keinen medizinischen Hintergrund hatte.

Interpretations-Fähigkeit wichtig

Den Ergebnissen der Studie zufolge haben die Mediziner bei der Einschätzung von Schmerz und Ärger wesentlich schlechter abgeschnitten als die andere Hälfte der Probanden. Hier lag die Trefferquote des Fachpersonals bei lediglich 54 Prozent, während die der restlichen Versuchsteilnehmer mit 83 Prozent erstaunlich hoch war. Für Ekel fielen die Ergebnisse beider Gruppen annähernd ähnlich aus.

"Das Gesicht eines Patienten zu interpretieren, kann dabei helfen zu bestimmen, ob dieser einen Schlaganfall erlitten hat, ob er Schmerzen hat oder, ob er auf die Medikation reagiert. Somit müssen Ärzte von Anfang an über diese Fähigkeit verfügen", schildert Studienleiterin Laurel Riek, Professorin für Computer Science und Engineering an der University of California, San Diego. Die Forschungsergebnisse sind kürzlich auf der Conference on Human-Robot Interaction in Wien http://bit.ly/2mlgIxR präsentiert worden.

(Ende)

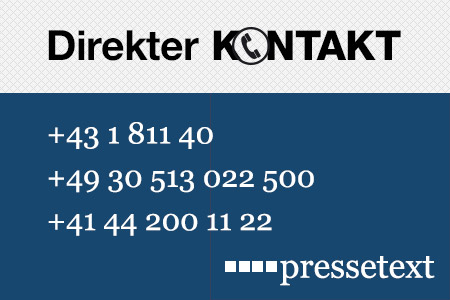

| Aussender: | pressetext.redaktion |

| Ansprechpartner: | Carolina Schmolmüller |

| Tel.: | +43-1-81140-314 |

| E-Mail: | schmolmueller@pressetext.com |

| Website: | www.pressetext.com |