KI-System DeepMind bekommt ein "Gedächtnis"

Algorithmus erlaubt neuralen Netzwerken das Anzapfen von Wissen

|

Klassiker: DeepMind spielt Atari-Videospiele (Foto: deepmind.com) |

London (pte024/16.03.2017/12:30) Googles DeepMind-Team http://deepmind.com hat zusammen mit Kollegen des Imperial College London http://imperial.ac.uk Künstliche Intelligenz (KI) auf die nächste Entwicklungsstufe gehoben. Ihnen ist es gelungen, einen Algorithmus zu programmieren, der neurale Computernetzwerke gewissermaßen mit einem "Gedächtnis" ausstattet, um aktuelle Herausforderungen durch das Anzapfen von gesammeltem Wissen aus der Vergangenheit effizienter zu lösen. Ein Praxistest mit klassischen Atari-Videospielen verlief erfolgreich.

"Signifikanter Mangel"

"Die Fähigkeit, die Lösung bestimmter Aufgaben sequenziell zu erlernen, ohne dabei bereits bestehendes Wissen zu vergessen, ist ein zentraler Bestandteil sowohl der biologischen als auch der KI", so die Forscher in ihrem "PNAS"-Beitrag. In letztgenanntem Bereich sei es bislang aber nicht möglich gewesen, auf eine Art Gedächtnis zurückzugreifen. "Es ist ein signifikanter Mangel, dass neuronale Netzwerke und KI bis jetzt nicht in der Lage waren, etwas, das sie im Zuge einer vorangegangenen Aufgabe gelernt haben, auch bei anderen Herausforderungen einzusetzen", sagt Studienautor James Kirkpatrick aus dem DeepMind-Team gegenüber "Wired".

Um das zu ändern, habe man den Algorithmus "Elastic weight consolidation" (EWC) entwickelt. "Unserem Ansatz nach werden KI-Systeme künftig wesentlich effizienter sein, weil der Algorithmus es ihnen ermöglicht, gezielt solche Fähigkeiten einzusetzen, die sie früher schon einmal erfolgreich erlernt haben", erklärt der Experte. Dieses funktioniere eigentlich gleich wie im menschlichen Gehirn. "Es geht um kontinuierliches Lernen auf Basis von synaptischer Zusammenlegung. Das ist das Grundgerüst für jedes Gedächtnis", erläutert Kirkpatrick.

Praxistest mit Atari-Videospielen

Bei einem ersten Praxistest wurde die Google-KI DeepMind auf tiefe, neurale Netzwerke - das sogenannte "Deep Q-Network" (DQN) - angesetzt, die es schon früher genutzt hatte, um zehn verschiedene klassische Atari-Videospiele zu meistern. Diesmal bekam die KI allerdings handfeste Unterstützung durch den EWC-Algorithmus. "Bislang musste das DQN lernen, wie man jedes einzelne Spiel individuell spielen kann. Durch die EWC-Erweiterung war es aber in der Lage, jedes dieser Videospiele nacheinander zu erlernen, ohne dabei an katastrophalem Gedächtnisverlust zu leiden", resümieren die Forscher.

Natürlich sei das System auch mit der EWC-Erweiterung noch lange nicht perfekt. "Im Moment haben wir zwar erfolgreich demonstriert, dass sequenzielles Lernen im KI-Sektor möglich ist. Wir konnten aber noch nicht abschließend zeigen, ob das automatisch auch die Lerneffizienz steigert", meint Kirkpatrick abschließend.

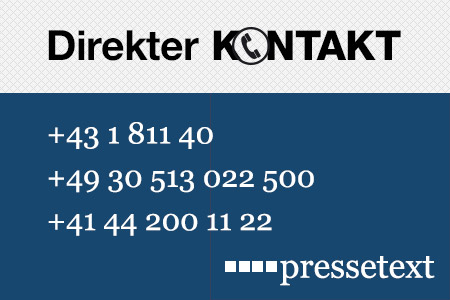

(Ende)| Aussender: | pressetext.redaktion |

| Ansprechpartner: | Markus Steiner |

| Tel.: | +43-1-81140-317 |

| E-Mail: | steiner@pressetext.com |

| Website: | www.pressetext.com |