Bewegungserfassung: System strippt User live

"DoubleFusion" digitalisiert damit Körperform statt die Bekleidung

|

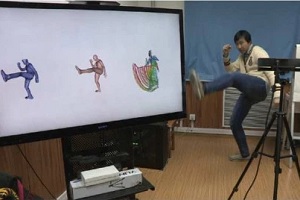

Hose weg: "DoubleFusion" erfasst Trittbewegung (Foto: liuyebin.com) |

Peking (pte029/19.06.2018/12:30) Ein internationales Forscher-Team hat mit "DoubleFusion" ein System zur Bewegungserfassung entwickelt, das den Nutzer gleichzeitig auch virtuell auszieht. Der Sinn dahinter ist, unabhängig von der getragenen Kleidung wirklich nur die menschlichen Körperformen zu digitalisieren. Das könnte dem Team zufolge diverse Anwendungen in den Bereichen AR und VR, Gaming, Unterhaltung oder auch für virtuelles Klamotten-Shoppen haben.

Echte Formen statt Kleidung

Für professionelle Motion-Capture-Verfahren in der Unterhaltungsindustrie müssen Darsteller hautenge, dünne Anzüge tragen. Denn andere Kleidung wie Jeans, schlabbrige Shirts oder gar Röcke würden zu Unsicherheiten bei der Erfassung der eigentlichen Körperform führen. Das anlässlich der diesjährigen Conference on Computer Vision and Pattern Recognition http://cvpr2018.thecvf.com vorgestellte System dient nun dazu, bei der Bewegungserfassung trotz Alltagskleidung nur den tatsächlichen Körper zu erfassen. "Mit DoubleFusion können sich User erstmals leicht selbst digitalisieren", meint daher das Team in seinem Paper für die Fachkonferenz.

Das System baut darauf auf, dass Kameras, die Tiefeninformationen erfassen, immer größere Verbreitung finden. Bisherige Ansätze, eben damit Körper zu digitalisieren, hatten aber noch Probleme mit schnellen Bewegungen und Kleidung. DoubleFusion setzt nun darauf, anhand der Tiefendaten und mithilfe der Verfolgung von Gelenken ein plausibles Skelett abzuschätzen und dann ein passendes Körpermodell darum aufzubauen. Dabei bereitet relativ dicke Kleidung noch Probleme, da das System diese eher als mehr Körpermasse interpretiert - also zu breite Körperformen erstellt.

Weitere Verfeinerungen als Ziel

In der aktuellen Form kann DoubleFusion gehaltene Gegenstände, wie beispielsweise einen Joystick, nicht erkennen und würde daraus seltsame Körperfortsätze machen. Doch will das Team unter Leitung der Tsinghua University http://www.tsinghua.edu.cn/english sich in Zukunft damit beschäftigen, wie die Interaktion von Personen mit Gegenständen aufgelöst werden kann. Denn die Forscher sind vom Potenzial der Entwicklung überzeugt. Das scheint auch plausibel. Bei einer virtuellen 3D-Ankleide für den Online-Einkauf beispielsweise wäre es ganz praktisch, weder einen Spezialanzug zu benötigen noch tatsächlich Nacktaufnahmen über das Internet übertragen zu müssen.

Zum CVPR-Paper "DoubleFusion: Real-time Capture of Human Performances with Inner Body

Shapes from a Single Depth Sensor": http://openaccess.thecvf.com/content_cvpr_2018/papers/Yu_DoubleFusion_Real-Time_Capture_CVPR_2018_paper.pdf

| Aussender: | pressetext.redaktion |

| Ansprechpartner: | Thomas Pichler |

| Tel.: | +43-1-81140-314 |

| E-Mail: | pichler@pressetext.com |

| Website: | www.pressetext.com |