Münzwurf effektiver: Crime-Software oft rassistisch

Enorme Fehlerquote nachgewiesen - Nur 20 Prozent tatsächlich rückfällig

|

Laptop: Software gegen Verbrechen rassistisch (Foto: schemmi/pixelio.de) |

New York (pte003/25.05.2016/06:05) Software, die bei der Einstufung von Kriminellen helfen und Wiederholungstaten verhindern soll, basiert überwiegend auf rassistischen Algorithmen. Menschen mit fremder Herkunft werden somit häufig voreingenommen katalogisiert. Zu diesem Ergebnis kommt eine aktuelle US-Studie des Non-Profit-Newsdesk ProPublica http://propublica.org .

Kuriose Markierungen

Dass analysierende Software für die Kategorisierung von Kriminellen seit Jahren genutzt wird, ist längst bekannt (pressetext berichtete http://pte.com/news/20110830030 ). Neu ist jedoch, dass die dahinter stehenden Algorithmen offenbar große Unterschiede zwischen der Herkunft der Täter machen - und damit alles andere als unvoreingenommen arbeiten.

In einer Analyse der Datenbankeinträge von über 7.000 Angeklagten in den USA wird dieses Phänomen mehr als deutlich. Die Auswertung von ProPublica zeigt auf, dass Afroamerikaner fast doppelt so häufig wie andere von der Software ganz automatisch als potenzielle Wiederholungstäter gekennzeichnet wurden.

Herkunft polarisierend

"Gerade einmal 20 Prozent der markierten Personen aus den Datenbanken wurden dann tatsächlich rückfällig", so die Forscher zu den Verweisen. Generell seien die Algorithmen ohnehin nur so effektiv wie ein Münzwurf, anstelle einer effektiven Vorhersage von Wiederholungstätern. Die Rasse der Registrierten sei zwar grundsätzlich ein Nebenfaktor, doch das Ausbildungslevel, die Arbeitstätigkeit und das soziale Umfeld trotzdem direkt mit der Herkunft verbunden.

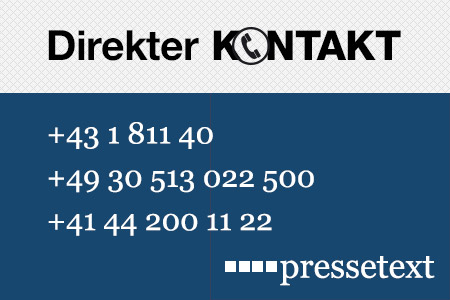

(Ende)| Aussender: | pressetext.redaktion |

| Ansprechpartner: | Sabrina Manzey |

| Tel.: | +43-1-81140-305 |

| E-Mail: | manzey@pressetext.com |

| Website: | www.pressetext.com |